- Suche öffnen

- Banken BankenConsultingProductsTechnology & Operations

- Consulting Consulting

- PaymentsPayments

- Cross-Border & High-ValueCross-Border & High-Value

- T2 (TARGET2)

- SWIFT gpi

- SWIFT MX

- Global Instant PaymentsGlobal Instant Payments

- Domestic PaymentsDomestic Payments

- Retail PaymentsRetail Payments

- Prozesse & IT-ArchitekturProzesse & IT-Architektur

- Regulatorische Anforderungen

- Trends

- Cross-Border & High-Value

- Bank der ZukunftBank der Zukunft

- ESG – Pflicht und Kür

- Data Driven BankingData Driven Banking

- KI in der FinanzindustrieKI in der Finanzindustrie

- BanksteuerungBanksteuerung

- Risikomanagement ArchitekturRisikomanagement Architektur

- Treasury ManagementTreasury Management

- Non-Financial Risk ManagementNon-Financial Risk Management

- ESG und BanksteuerungESG und Banksteuerung

- ESG RisikomanagementorganisationESG Risikomanagementorganisation

- ESG-Guidelines

- ESG Offenlegung

- Finance Sustainability

- ESG Risikomanagementorganisation

- IT-RisikomanagementIT-Risikomanagement

- Sparkassen im WandelSparkassen im Wandel

- Finance

- Risikomanagement Architektur

- Regulatorik & ComplianceRegulatorik & Compliance

- FinanzdienstleistungsaufsichtFinanzdienstleistungsaufsicht

- Crime Prevention

- RegTechRegTech

- Compliance-ManagementCompliance-Management

- Wertpapier-ComplianceWertpapier-Compliance

- MiFID

- MiFID KernthemenMiFID Kernthemen

- Marktmanipulation & Insiderhandel

- Wertpapiergeschäft & eWpGWertpapiergeschäft & eWpG

- ESG-ComplianceESG-Compliance

- EU AI Act

- Finanzdienstleistungsaufsicht

- KreditgeschäftKreditgeschäft

- Digital BankingDigital Banking

- Digitales KundenmanagementDigitales Kundenmanagement

- Digitale ÖkosystemeDigitale Ökosysteme

- Digitale GeschäftsprozesseDigitale Geschäftsprozesse

- Digitales Kundenmanagement

- Business TransformationBusiness Transformation

- Payments

- Products Products

- Payments ProductsPayments Products

- Banking Solutions

- Payments Products

- Technology & Operations Technology & Operations

- Change- & Run-the-BankChange- & Run-the-Bank

- Cloud JourneyCloud Journey

- Agile & TransformationAgile & Transformation

- Individuelle Softwareentwicklung

- Change- & Run-the-Bank

- Consulting

- Versicherungen VersicherungenConsultingTechnology & Operations

- Consulting Consulting

- Practical AI

- Technologiegetriebene TransformationTechnologiegetriebene Transformation

- ESG

- Intelligente AutomatisierungIntelligente Automatisierung

- Aktuarielle Beratung

- Compliance

- Referenzen & Success Stories

- Products

- Technology & Operations Technology & Operations

- Consulting

- Academy

- Insights Insights

- Über PPI Über PPICompany

- Company Company

- UnternehmensgruppeUnternehmensgruppe

- Corporate Social ResponsibilityCorporate Social Responsibility

- Compliance Center

- Unternehmensgruppe

- Touchpoints

- Company

- Karriere KarriereJobs bei PPIArbeiten bei PPI

- Jobs bei PPI Jobs bei PPI

- Arbeiten bei PPI Arbeiten bei PPI

- Leben bei PPI Leben bei PPI

- Jobs bei PPI

- DE

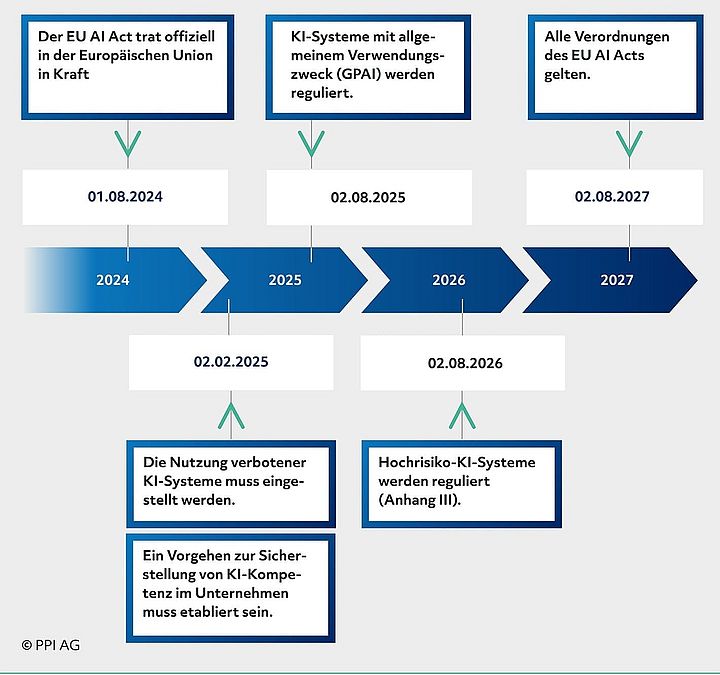

Die EU AI Act Timeline gibt Orientierung, wann welche regulatorischen Maßnahmen für KI gelten. Für Versicherungen heißt das: vom Aufbau der Governance über Risk Assessments bis zu CE‑ähnlichen Konformitätsprüfungen für Hochrisikosysteme. Der EU AI Act macht deutlich, dass ein integrierter KI‑Lifecycle samt Monitoring und Reporting Pflicht wird. Unternehmen, die Zeitpläne nicht berücksichtigen, riskieren Nachrüstaufwand, Betriebsunterbrechungen und empfindliche Sanktionen.

EU AI Act: Folgen, Pflichten und Prioritäten für Versicherer

Der EU AI Act etabliert erstmals eine umfassende, risikobasierte Regulierung für KI‑Systeme. Für Versicherer bedeutet das, dass KI‑gestützte Anwendungen in Underwriting, Pricing und Schadenmanagement nicht mehr nur technologisch bewertet werden – ihre Einordnung nach Risikoklassen entscheidet über Pflichten, Nachweislast und mögliche Sanktionen. Die EU AI Act Timeline signalisiert klare Meilensteine: Eintritt der Verordnung, schrittweise Umsetzungsfristen und die Phase, ab der Hochrisikosysteme verbindlich reguliert werden.

Welche Anforderungen stellt der EU AI Act?

Der EU AI Act verknüpft die regulatorischen Pflichten direkt mit den Phasen des KI‑Lifecycles. Das heißt: Compliance muss entlang des gesamten Prozesses nachweisbar sein – von der Projektinitiierung bis zur Stilllegung. Die wichtigsten Anforderungen entlang des KI-Lifecycles:

- Vor Projektstart: Klare Verantwortlichkeiten und Rollen müssen benannt werden. Ein Risikomanagementsystem ist zu etablieren, das Entscheidungen, Freigaben und Eskalationswege dokumentiert.

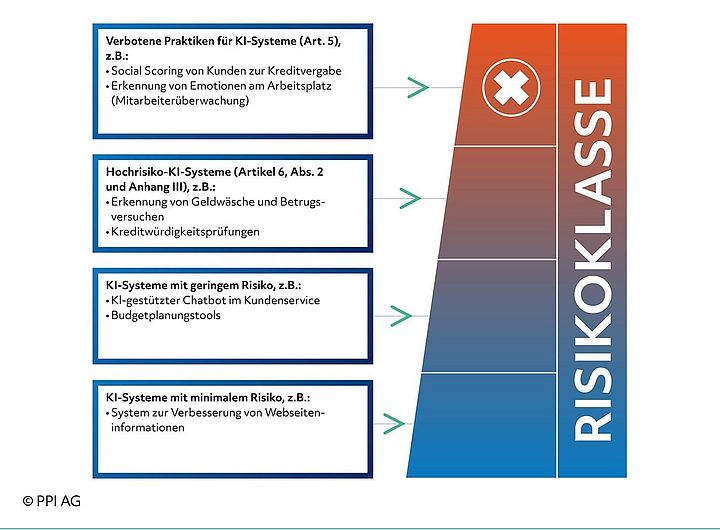

- Anforderungs- und Risikomanagement: Jede Anwendung ist nach Risikoklassen zu bewerten. Die Einordnung (verboten, Hochrisiko, geringeres Risiko) bestimmt Umfang und Tiefe der weiteren Anforderungen – insbesondere Hochrisikosysteme unterliegen strengen Auflagen. Data Governance muss die Herkunft, Zweckbindung und Qualitätskriterien für Trainings‑, Validierungs‑ und Testdaten sichern. Bias‑Analysen und Datenprovenienz sind dokumentpflichtig.

- Modellumsetzung und -test: Modelle sind methodisch zu validieren. Robustheit, Genauigkeit und Fairness müssen belegt werden. Testprotokolle und Evaluationsergebnisse sind zu archivieren.

- Deployment und Monitoring: Systeme sind fortlaufend zu überwachen. Ereignisse und wesentliche Änderungen müssen automatisch protokolliert werden; Vorfälle sind dokumentiert zu analysieren und zu melden. Für bestimmte Anwendungen sind menschliche Kontrollinstanzen Pflicht.

- Sanktionen: Nichteinhaltung kann zu erheblichen Bußgeldern und operativen Einschränkungen führen. Die regulatorische Nachweispflicht macht aus punktuellen Prüfungen eine dauerhafte Governance‑Aufgabe.

Welche Regularien gelten für KI in der Versicherung?

Als Finanzunternehmen gelten für Versicherungen neben dem EU AI Act weitere Verordnungen und Richtlinien, die das Betreiben von KI-Systemen beeinflussen. Es ist elementar, das Netzwerk der verschiedenen Vorschriften zu verstehen: Neben dem EU AI Act sind dies die NIS2-Richtlinie, die DORA-Verordnung und zukünftig FIDA.

Mit unserem Discussion Paper erlangen Sie den Überblick über das Bürokratiedickicht rund um KI in der Versicherung:

Welche Risikoklassen definiert der EU AI Act?

Der EU AI Act unterscheidet verbotene Praktiken, Hochrisikoanwendungen und geringere Risikoformen. Für Hochrisiko‑KI gelten umfangreiche Anforderungen: Risikomanagement über den gesamten Lifecycle, umfassende technische Dokumentation, Data Governance und Nachvollziehbarkeit. Schon die Klassifizierung einer Anwendung entscheidet darüber, ob zusätzliche Audit‑ und Konformitätsmaßnahmen nötig werden.

Welche Besonderheiten gelten für General Purpose AI?

General Purpose AI (GPAI) bezeichnet Modelle, die nicht auf einen engen Anwendungsfall beschränkt sind, sondern vielseitig einsetzbar sind. Der EU AI Act nimmt GPAI‑Modelle besonders in den Blick: Leitlinien und Entwürfe zur Behandlung von GPAI adressieren Schwellenwerte, zusätzliche Meldepflichten und Kriterien zur Einstufung des Systemrisikos.

Für Versicherungen ist relevant, ob eingesetzte Modelle als GPAI gelten, denn das kann Auswirkungen auf die Risikoklassifizierung haben. GPAI kann bestehende Anwendungen in eine höhere Risikokategorie heben (siehe unten), weil die Vielseitigkeit und Reichweite der Modelle zu größerer Unsicherheit bei Bias, Robustheit und Datenherkunft führt.

Können wir Sie unterstützen?